VEGA

Superračunalnik Vega je bil naročen kot primarni superračunalniški sistem projekta za nadgradnjo slovenskih nacionalnih raziskovalnih infrastruktur “HPC RIVR” in dobavljen kot eden prvih sistemov Skupnega podjetja EuroHPC. Postavljen je na lokaciji Instituta informacijskih znanosti, Maribor (IZUM). Povečal je računsko moč v Sloveniji in celotni Evropski uniji in pomagal bo raziskovalcem ter drugim uporabnikom, tako v javnem kot v zasebnem sektorju.

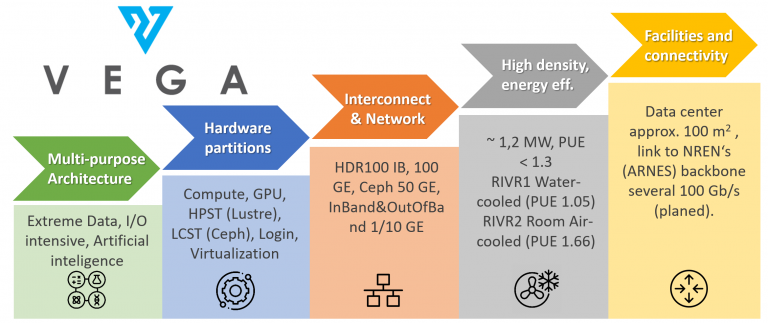

HPC Vega je gonilna sila inovacij, ki Evropi pomaga v globalni konkurenčnosti na strateških področjih, kot so umetna inteligenca, napredna podatkovna analitika (HPDA), personalizirana medicina, bioinženiring, boj proti podnebnim spremembam ter razvoj zdravil in novih materialov. Glavne lastnosti HPC Vega so opisane spodaj:

Superračunalnik ima 960 vozlišč centralnih procesnih enot (skupno 1920 centralnih procesnih enot AMD Epyc 7H12 – 122.000 jeder) in 60 vozlišč grafičnih procesnih enot (skupno 240 grafičnih procesnih enot NVidia A100), trajna zmogljivost HPC Vega je 6,9 PFLOPS (najvišja zmogljivost je 10,1 PFLOPS).

Električno napajanje in hladilna infrastruktura superračunalnika HPC Vega sta razdeljena na več področij. En 1,6‑MVA 10k/400V transformator je nameščen v ločenem prostoru, celotno poslopje pa je varovano s pomožnim dizelskim generatorjem 820 kVA.

Podjetje Atos je dobavilo in namestilo 12 tekočinsko hlajenih strežniških omar BullSequana za računska vozlišča v sistemskem prostoru RIVR1. Računski del v RIVR1 je podprt z avtonomnim nekajminutnim brezprekinitvenim napajanjem (UPS), ki omogoča nemoten postopek zaustavitve. Adiabatski hladilni sistem je nameščen za toplovodni režim z dovodom 35 °C in odvodom 50 °C, kar omogoča hlajenje 90 % časa in je učinkovit do zunanje temperature 33 °C. Ta sistem je nameščen na strehi stavbe IZUM, v kleti pa je hladilnik za RIVR1. Ta sistem lahko zagotavlja hlajenje do 880 kW toplotnih izgub v RIVR1.

Prostor RIVR2 je opremljen s klasičnim klimatskim hlajenjem v vrsti. Nameščenih je 7 standardnih strežniških omar za 61 pomnilniških vozlišč Ceph, 10 pomnilniških vozlišč DDN, 30 virtualizacijskih/servisnih vozlišč in 8 prijavnih vozlišč. Ena širša strežniška omara je namenjena komunikacijski opremi. Usmerjevalniki so nameščeni v ločenem sistemskem prostoru za telekomunikacije. Poraba elektrike na območju sistema RIVR2 je omejena na 110 kW. V primeru izpada električne energije je z napajanjem iz brezprekinitvenega napajanja (UPS) in dizelskega generatorja oskrbovan samo sistemski prostor RIVR2. V RIVR2 je na voljo dodatni hladilni sistem s standardnim režimom hladne vode.

Pregled sistema

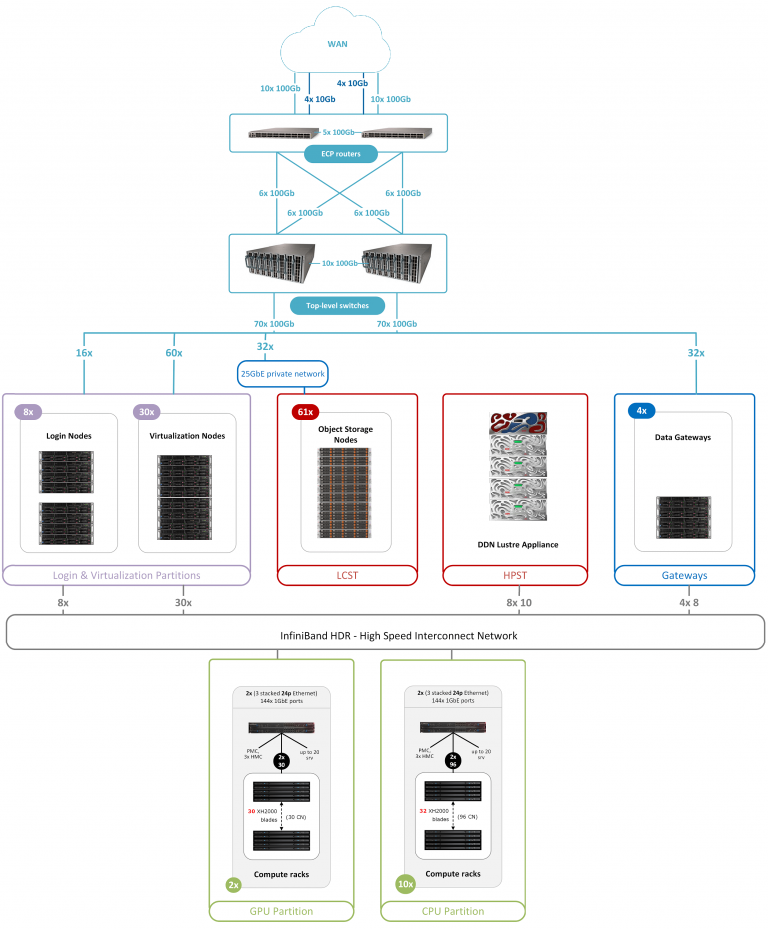

Tipologija omrežja je prikazana spodaj:

Povezljivost in infrastruktura omrežja

Povezljivost WAN superračunalnika Vega s hrbteničnim omrežjem ARNES je redundantna, zagotovljena pa je z usmerjevalniki CPE. Glavni cilji so zagotovitev zadostne pasovne širine do drugih podatkovnih centrov in superračunalnikov v omrežju SLING, Evropski uniji in po vsem svetu za prenos velikih količin podatkov ter za kakovostno, zanesljivo in varno povezljivost za vse skupnosti uporabnikov.

Omrežje Ethernet na najvišji ravni je sestavljeno iz dveh CPE-usmerjevalnikov Cisco Nexus N3K – C3636C-R, ki se uporabljata za redundantno povezljivost 5 x 100 GbE do WAN do hrbteničnega omrežja (ki bo urejeno do konca leta 2021) in dveh stikal Ethernet na najvišji ravni Cisco Nexus N3K – C3408-S (192 vrat, aktivirano 100 GE), ki se uporabljata za redundantne povezave za vozlišča v prijavnih, virtualizacijskih in servisnih particijah ter za pomnilniške podsisteme in nivo visokozmogljivega pomnilnika (HPST) ter nivo pomnilnika z veliko kapaciteto (LCST).

Omrežje za glavno upravljanje je sestavljeno iz dveh stikal Mellanox 2410 (na stikalo 48 vrat 10 GbE). Vhod/izhod omrežja za upravljanje pasovne širine je sestavljen iz več stikal Mellanox 4610 (na stikalo 48 vrat 1 GbE in dvoje vrat 10 GbE), omrežje za upravljanje strežniških omar pa je sestavljeno iz integriranih stikal BullSequana WELB (sWitch Ethernet Leaf Board) s tremi 24-vratnimi stikali Ethernet in eno napravo za upravljanje Etherneta (EMC).

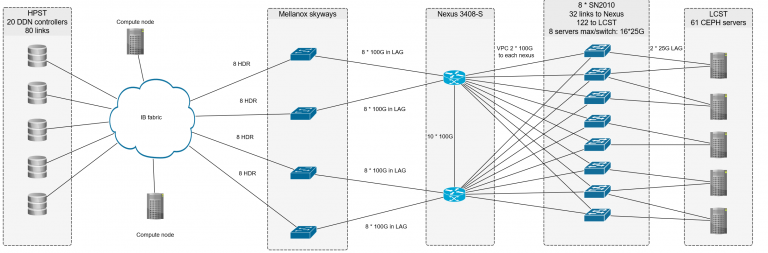

Medsebojna povezljivost in podatkovni prehodi

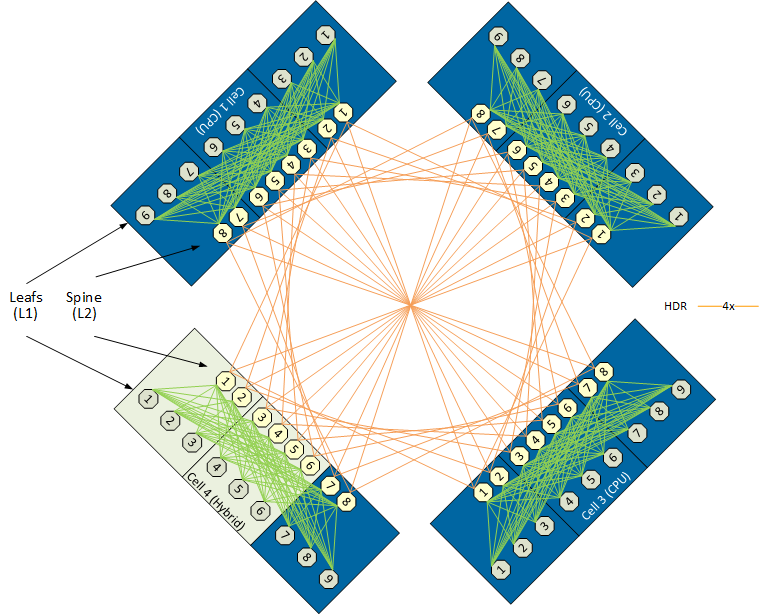

Medsebojno omrežje je sestavljeno iz 68 40-vratnih stikal Mellanox HDR s topologijo Dragonfly+.

Vsa pomnilniška vozlišča, torej 960 računskih, 60 GPU, 8 prijavnih, 30 virtualizacijskih, 10 HPST vozlišč, in 8 prehodov Skyway je povezanih z Mellanox ConnectX-6 (enojna ali dvojna vrata).

Uporabljajo se štirje prehodi NVIDIA (Mellanox) Skyway GA100 IP/podatkovni prehodi z 8 povezavami na vsaki strani za usmerjanje IP-prometa med omrežjem Infiniband na računski gruči in LCST na osnovi Ceph. S tem pristopom imajo računska vozlišča dostop do interneta in tako se lahko izvaja interakcija z drugimi podatkovnimi viri prek zaščitenih omrežij, kot je LCHONE.

Računske particije

Particija CPU (centralne procesne enote) je sestavljena iz 10 strežniških omar BullSequana XH2000 DLC, ki vključujejo naslednje:

768 standardnih računskih vozlišč (v 256 rezinah); vsako vozlišče ima:

- 2 procesorja AMD EPYC Rome 7H12 (64c, 2,6 GHz, 280 W), 256 GB RAM-a DDR4‑3200, 1 x HDR100 mezzanine z enimi vrati, 1 x lokalni 1,92 TB M.2 SSD.

192 računskih vozlišč z velikim pomnilnikom (v 64 rezinah); vsako vozlišče ima:

- 2 procesorja AMD EPYC Rome (64c, 2,6 GHz, 280 W), 1 TB RAM-a DDR4-3200, 1 x HDR100 mezzanine z enimi vrati, 1 x 1,92 TB M.2 SSD.

Particija GPU (grafične procesne enote) je sestavljena iz 2 strežniških omar BullSequana XH2000 DLC, ki vključujeta naslednje:

60 vozlišč GPU (60 rezin); vsako vozlišče ima:

- 2 procesorja AMD EPYC Rome (64c, 2,6 GHz, 280 W), 512 GB RAM-a DDR4-3200, lokalni 1,92 TB M.2 SSD;

- 4 grafične procesne enote NVIDIA Ampere A100 PCIe (3456 jeder FP64 CUDA, 432 jeder Tensor, najvišja zmogljivost jeder FP64 je 9,7 TFLOPS, jeder FP64 Tensor pa 19,5 TFLOPS), vsaka s 40 GB HBM2 in maks. vrednostjoTDP 400 W.

Superračunalnik Vega je sestavljen iz 1020 računskih vozlišč z najmanj 256 GB RAM-a, kar je skupno 130.560 jeder CPU. Trajna zmogljivost na vseh enotah CPU je 3,8 PFLOPS. 240 pospeševalnikov GPU s skupno 829.440 jedri FP64 CUDA in 103.680 jedri Tensor zmore 3,1 PFLOPS.

Nivo visokozmogljivega pomnilnika (HPST) – Lustre

HPST sestavlja 10 gradnikov DDN ES400NVX; vsak od teh vključuje:

- osnovno ohišje ES400NVX z 1+1 krmilniki za redundantni pomnilnik ter popolnoma redundantne poti IO do pomnilniških naprav, redundantni ventilatorji in napajalniki;

- 23 naprav 6,4 TB NVMe (DWPD=3), formatiranih s tehnologijo flash pools 2 x 10/0;

- 1 naprava NVMe kot medij HotSpare, 8 sprednjih vrat InfiniBand HDR100;

- 4 vgrajene virtualne naprave (VM) za delovanje Lustre vOSS in vMDS z 1 OST in 1 MDT na VM.

Gradnik zagotavlja kapaciteto 111 TB, ki se lahko formatira. Po namestitvi zgornjega datotečnega sistema je uporabna kapaciteta Lustre pribl. 1 PB za podatke in največ 5 milijard inod v sistemu. Zmogljivost hitrega pomnilnika (maks. branje in zapisovanje) je več kot 400 GB/s. HPST na osnovi Lustre predstavlja diskovne kapacitete za delovni prostor za zahtevne aplikacije I/O in velike posle.

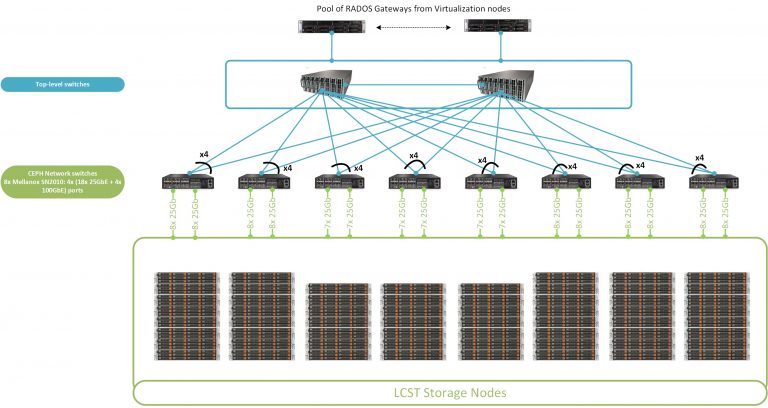

Nivo pomnilnika z veliko kapaciteto (LCST) – Ceph

LCST vsebuje 61 strežnikov Supermicro SuperStorage 6029P-E1CR24L, vsak od teh vključuje naslednje:

- 2 procesorja Intel Xeon Silver 4214R (12c, 2,4 GHz, 100 W), RAM 256 GB DDR4 2933;

- 2 sistemska diska 6,4 TB NVMe in 24 podatkovnih diskov 16 TB 3,5″ SATA3 7200 RPM

- 2 x 25 GbE SFP28 do zasebnega internega omrežja.

Dva diska NVMe SSD na strežnik zagotavljata 12,8 TB celotne kapacitete NVMe skupno na vozlišče OSD. Vsak strežnik ima kapaciteto trdih diskov 384 TB in skupno najmanj 19 PB uporabnega pomnilnika Ceph (s 16+3 kodiranimi bazeni, ki se lahko izbrišejo). Interno omrežje Ceph vsebuje 8 stikal Mellanox SN2010, vsako od teh 18 vrat 25 GbE in 4 vrata 100 GbE.

Zmogljivost pomnilnika Ceph je več kot 200 GB/s. LCST na osnovi Ceph predstavlja diskovne kapacitete za:

- dolgoročne storitve (sistemske storitve in virtualizacijo v oblaku),

- uporabniške domače direktorije (privzeto 100 GB na uporabniški račun),

- prostor projektne skupine v skupni rabi in dolgoročne shrambe znanstvenih podatkov.

Prijavna vozlišča

4 prijavna vozlišča CPU Atos BullSequana X430-A5 so sestavljena iz:

- 2 x AMD EPYC 7H12 (enako kot na particiji CPU),

- 256 GB RAM-a DDR4 3200, 2 x lokalni 7,6 TB U.2 SSD

- 1 x 100 GbE DP ConnectX5, 1 x 100 Gb IB HDR ConnectX-6 SP.

4 prijavna vozlišča GPU Atos BullSequana X430-A5 so sestavljena iz:

- 1 x PCIe GPU NVIDIA Ampere A100 z 40 GB (enak model kot na particiji GPU)

- 2 x AMD EPYC 7452 (32c, 2,35 GHz, 155 W)

- 256 GB RAM-a DDR4 3200, 2 x lokalni 7,6 TB U.2 SSD

- 1 x 100 GbE DP ConnectX5 in 1 x 100 Gb IB HDR ConnectX-6 SP.

Na prijavnih vozliščih lahko uporabniki testirajo svoje aplikacije na enakih centralnih in grafičnih procesnih enotah kot na particijah CPU in GPU.

Virtualizacijska in servisna particija

30 virtualizacijskih vozlišč Atos BullSequana X430-A5 je sestavljenih iz:

- 2 x AMD EPYC 7502 (32c, 2,5 GHZ, 180 W)

- 512 GB RAM-a DDR4 3200

- 2 x 7,6 TB U.2 SSD

- 1 x 100 GbE DP ConnectX5 in 1 x 100 Gb IB HDR ConnectX-6 SP

Virtualizacijska in servisna particija se uporabljata za splošne namene dolgoročnih storitev, administrativne naloge in naloge, ki ne ustrezajo računskim particijam, particijam GPU in prijavnim particijam. V glavnem se uporabljata za sistemske storitve in infrastrukturo v oblaku.

Programsko okolje

- Sistemska programska oprema Atos: Smart Management Center, Bull Energy Optimizer, Performance Toolkit, IO Instrumentation

- Nadzor, opozorila: DDN Insight Monitoring Software & ExaScaler Software Monitoring, programska oprema Clary & Inventory, Prometheus, Grafana, Icinga, NVIDIA NSight

- Upravitelj delovnih obremenitev: Bull Slurm

- Orkestracija: BlueBanquise, Ansible

- Dostop do zunanjih virov: NorduGrid ARC, dCache, CVMS

- Operacijski sistem računskih vozlišč: Red Hat Enterprise Linux 8

- Virtualizacija v oblaku/vrtualizacija storitev: Proxmox, RHEV, oVirt

- Sklad programske opreme: Komplet EasyBuild, moduli (Lmod)

- Prevajalniki in SDK: Prevajalniki Intel (licencirani Parallel Studio XE), TotalView (licencirani), GCC, AMD Optimizing C/C++ Compiler, NVIDIA SDK

- Kompleti MPI: OpenMPI, IntelMPI

- Programski jeziki: Python, Fortran, C/C++, R, Julia, Go, Scala

- Numerične, podatkovne in vzporedne/pospeševalne knjižnice: BLAS, LAPACK/ScaLAPACK, MKL, BLIS, FFTW, HDF5, netCDF, Eigen, ARPACK, CUDA, cuDNN, cuFFT, cuRAND, cuSOLVER, cuSPARSE, cuTENSOR, TensorRT, KOKKOS, Jarvis, DeepStream SDK, DALI, AmgX, NCCL, Intel TBB, nvGRAPH, Thrust, nvJPEG, NVIDIA Performance Primitives, Video Codec SDK, Optical Flow SDK.

- Ogrodje: PyTorch, TensorFlow

- Vsebniki: Singularity Pro, Docker

- Drugo: Oddaljen uporabniški vmesnik za posredovajne x11, uporabniško licenciran Matlab

Particije Slurm: Privzeta particija se imenuje cpu. Omejitve virov, seznam vozlišč in informacije o pomnilniku so predstavljeni v naslednji tabeli:

| Partition | Nodes | Time limit | Node list | Memory |

|---|---|---|---|---|

| Dev | 8 | 1:00 | login[0001-0008] | 257496MiB, 251GiB |

| Cpu | 960 | 2-00:00:00 | cn[0001-0960] | 257470MiB, 251GiB |

| Longcpu | 22 | 4-00:00:00 | cn[0010-0025,0400-0405] | 257470MiB, 251GiB |

| Gpu | 960 | 4-00:00:00 | gn[01-60] | 515517MiB, 503GiB |

| Largemem | 192 | 2-00:00:00 | cn[0385-0576] | 1031613MiB, 1007GiB |

Dokumentacija HPC Vega: https://doc.vega.izum.si

Področja uporabe

Obstaja več področij in aplikacij, na katerih so slovenski strokovnjaki in strokovni raziskovalci razvili napredne pristope oziroma so te del razvoja. Na teh področjih sta predvidena ciljna podpora na visokem nivoju in vzajemni razvoj za obsežno uporabo infrastrukture s strani uporabniških skupnosti in projektov. Ta področja in aplikacije vključujejo naslednje:

- Strojno učenje, vključno s postavitvijo aplikacij na osnovi vsebnikov in na osnovi optimiziranih vektorjev/GPU za domensko-specifične sisteme kot tudi splošna ogrodja (PyTorch, Theano, Caffe, Tensorflow) z optimizacijami za souporabo pospeševalnikov, medsebojno povezovanje in arhitekturne izzive RDMA ter nove postavitve.

- Biomolekularne simulacije in simulacije materialov na osnovi molekularne dinamike v polju sil, s podporo NAMD, Gromacs, Amber in LAMMPS. Modeliranje reakcij encimov s tehnikami na osnovi pristopa empirične valence vezi.

- Kvantna kemija in modeliranje materialov ter simulacije s podporo za Gaussian, NWchem, ORCA in VASP ter preostalih priljubljenih paketov.

- Raziskava materialov z obsežnimi simulacijami Monte Carlo za polimere, analizo napak na tekočih kristalih s Quantum ESPRESSO. Prizadevanja v integraciji med strojnim učenjem, modeli ab-initio in Monte Carlo v progresivnih sistemih v fiziki osnovnih delcev, kvantni kemiji, znanosti o materialih in raziskavah o kompleksni materiji.

- Medicinska fizika, hitra, morda on-line, analiza na osnovi GPU za medicinske vzorce z uporabo rešitev RTE medijev v plasteh.

- Neuravnotežena kvantna in statistična fizika, dinamične in statistične lastnosti večdelnih sistemov.

- Simulacije dinamike tekočin in analiza v fiziki reaktorjev in tehnologije, raziskave in simulacija v teoriji prenosa delcev (nevtroni, protoni) z okolji Singularity in Docker za simulacije Monte Carlo za fiziko jedrskih reaktorjev, raziskovalno fiziko reaktorjev, jedrsko fuzijo, ocenjevanje jedrskih podatkov in fiziko plazme.

- Astrofizika, rudarjenje podatkov v velikih astrofizikalnih skupnih naborih podatkov (Pierre Auger v Argentini in CTA), modeliranje sevanja iz astrofizikalnih struktur. Simulacija na osnovi CORSIKA in analiza zračnih prh z visokoenergetskimi delci kozmičnih žarkov.

- Fizika osnovnih delcev, obdelava podatkov na ekstremni ravni, simulacija detektorjev, rekonstrukcija podatkov in distribuirana analiza, ATLAS v CERN-u, eksperiment Belle2 v KEK-u na Japonskem.

- Bioinformatika (Megamerge, Metamos), optimizacije skupnega razvoja in pretoka podatkov za človeško genomiko (GATK, Picard) s številnimi aplikacijami v raziskavah o ljudeh, živalih in rastlinah kot tudi v medicini in medicinski diagnostiki.

- Dinamika in simulacija ognja (FDS), dinamika tekočin z OpenFOAM.

- Obdelava medicinskih slik in raziskovalna dela z analizo ter modeliranjem medicinskih slik v fiziki medicine.

- Obdelava satelitskih in astronomskih slik, obdelava GIS z uporabno sodobnih skalabilnih pristopov strojnega učenja, osnovnega programiranja in programiranja za posredovanje sporočil z novimi arhitekturami in medsebojnimi povezavami, podporo za osnovne matematične in računske knjižnice, vključno z Octave, Sage, Scilab.

Sodelovanje med disciplinami, skladi programske opreme in sistemske rešitve so se izkazali za zelo učinkovito navzkrižno-razvojno in interdisciplinarno delo, zlasti v povezavi z disciplinami IKT, strojnim učenjem, obdelavo podatkov, navzkrižno oprašitvijo podrobnega modeliranja, simulacijo Monte Carlo in analizo signalov, optimiziranim modeliranjem in modelom za strojno učenje, s posebnim poudarkom na introspektivnem strojnem učenju, v naboru pristopov fizike osnovnih delcev, računske kemije od kvantnih ravni do zlaganja proteinov ter kompleksnih analiz in modeliranja materije.

Primerjalno preizkušanje

Proces nabave sistema Vega je temeljil na naslednjem seznamu programov za primerjalno preizkušanje (angl. benchmarks) za ocenjevanje predloženih prijav na razpis:

Sintetični programi za primerjalno preizkušanje:

- Linktest

- IMB

- HPL

- HPCG

- STREAM

- IOR

- Mdtest

- Iperf3

- Firestarter

Aplikacijski programi za primerjalno preizkušanje:

- GROMACS

- Quantum ESPRESSO

- HEPSpec06

- OpenFOAM

- TensorFlow Resnet-50